Uno de los principales riesgos a los que nos exponemos en redes sociales electrónicas, es a ser sujetos de la ciber-violencia, esto es, cualquier forma de agresión en medios digitales. No es complicado encontrar ejemplos de agresividad, por ejemplo, en foros o sitios en donde el usuario puede expresar una opinión o plantear una postura ante determinados objetos, expresiones o eventos. La proliferación de este tipo de ataques ha motivado el estudio y desarrollo de tecnología que permita detectar casos de agresión textual: esto es, programas de computadora que detectan agresividad en mensajes escritos en redes sociales. Estos poli-bots (bots policiacos) se basan en diferentes principios, mayormente apoyados en inteligencia artificial. Por ejemplo, algunos utilizan técnicas de procesamiento de lenguaje natural —específicamente de análisis de sentimiento— al emplear listados de palabras ofensivas para identificar ocurrencias de este tipo de palabras y con ello determinar si el texto es agresivo; otros métodos buscan patrones específicos (por ejemplo, la ocurrencia de determinados pronombres y formas de verbos). Los métodos de aprendizaje máquina, igualmente populares para este tipo de tareas, procesan offline algunos comentarios que han sido identificados como agresivos (llamados “de entrenamiento”) y tratan de determinar (aprender) patrones del uso de palabras en dichos comentarios. Una vez que se aprenden estos patrones, se pueden usar para identificar agresividad en textos nuevos, que no se consideraron para el proceso de aprendizaje.

Aunque existen algunos métodos para detectar agresividad en textos escritos en redes sociales, en general, este tipo de técnicas tiene un enfoque “forense”. Es decir, son poli-bots que monitorean redes sociales tratando de identificar comentarios que ya han sido publicados, y que probablemente han estado publicados durante algún tiempo. Así, el objetivo principal de estos métodos es identificar un comentario agresivo, y sugerir eliminarlo. Este tipo de soluciones es útil para identificar a usuarios ofensivos, detectar patrones de agresividad, estudiar la interacción víctima-agresor, etcétera. Sin embargo, estos métodos carecen de una funcionalidad crítica: no permiten anticipar agresiones y/o prevenirlas.

Es solo recientemente, que se ha propuesto el desarrollo de tecnología preventiva: programas de computadora que detecten un comentario agresivo antes de que éste se haga público o inmediatamente después. El objetivo de estos poli-bots preventivos es monitorear en todo momento la generación de comentarios o mensajes, y emitir una alerta tan pronto como sea detectado que el contenido podría ser agresivo. Como es de esperarse, se trata de un problema más complejo: se debe operar con información parcial o incompleta, lo que hace más complicado detectar patrones de uso de palabras; se debe monitorear continuamente las redes sociales, lo que plantea retos de escalabilidad; se debe tener más cuidado en cometer errores, pues preetiquetar erróneamente un comentario como agresivo puede tener consecuencias graves. No obstante las complicaciones, hoy en día el estudio de técnicas para la clasificación anticipada de fragmentos de texto es un tema trascendental en el campo de tratamiento automático de lenguaje.

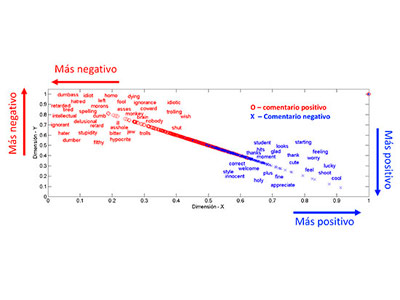

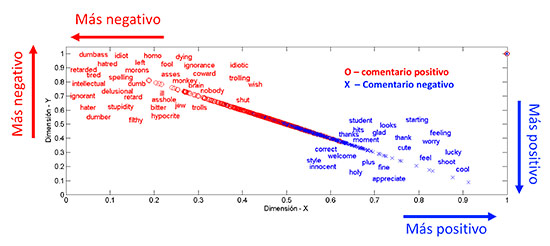

Los métodos de reconocimiento anticipado de texto existentes se basan en modificaciones a métodos estándar (aquellos que se usan a posteriori) que les permiten operar efectivamente con información incompleta. Algunos de ellos usan técnicas de modelado probabilista que les permiten acumular la evidencia, y proveer mejores predicciones conforme más información se tiene disponible1. Otros métodos utilizan modelos predictivos para datos secuenciales2. Más recientemente, se ha mostrado que mejores resultados en reconocimiento anticipado de texto agresivo se pueden lograr mediante el uso de representaciones concisas de palabras3. La idea básica es representar cada palabra en un espacio vectorial donde palabras que aparecen en textos de agresividad se encuentran cerca unas de otras, y al mismo tiempo se encuentran lejos de palabras que aparecen en textos donde no hay agresividad. Así, es posible medir la distancia entre palabras. Fragmentos de texto de cualquier tamaño (conteniendo al menos una palabra), también pueden representarse en ese espacio (ver Figura). Sacando ventaja de este hecho, las representaciones se usan efectivamente para detectar texto agresivo usando únicamente información parcial. Resultados reportados en la literatura han mostrado que es promisorio detectar anticipadamente textos agresivos mediante esta metodología.

No obstante lo prometedor de los resultados, es un hecho que estamos aún lejos de poner en práctica la tecnología que nos permita estar seguros de agresiones textuales. Sin embargo, la importancia de esta tecnología es tal, que diferentes grupos de científicos e ingenieros alrededor del mundo trabajan en el desarrollo de soluciones. Para ilustrar la importancia de esta tecnología, consideremos un contexto totalmente relacionado con agresión textual: el ciber-acoso en redes sociales digitales. Este fenómeno afecta seriamente a niños y jóvenes y, contrario al acoso común, no está confinado a las aulas o a los horarios de clases. Asimismo, el ciber-acoso es más agresivo que el acoso común, dado que el agresor se escuda detrás de un monitor o un dispositivo móvil. Existen algunos métodos para la detección automática de ciberacoso en redes sociales digitales. Sin embargo, la detección de ciberacoso aún se encuentra en su infancia, pues presenta —entre otros aspectos— varias modalidades de información. Por ejemplo, el sexting consiste en exhibir y compartir fotografías inapropiadas del acosado, y por tanto, requiere métodos de procesamiento de imágenes. En este contexto es vital el desarrollo de métodos de detección temprana, pues el ciber-acoso puede degenerar en consecuencias graves para la víctima, desde cambios en su personalidad y hábitos, hasta el suicidio. Es importante mencionar que hay muchos otros dominios en los cuales es vital implementar mecanismos preventivos para detectar eventos en redes sociales. Por ejemplo, la detección temprana de depredadores sexuales en salas de chat, o bien, la detección anticipada de casos de depresión severa a partir de los tweets de usuarios.

Sin duda alguna, tecnología que permita aliviar, o atenuar las consecuencias de la agresión textual es vital para el adecuado uso de las redes sociales digitales. Mientras tal tecnología llega a nuestros círculos sociales, no nos queda más que protegernos de agresiones de la manera tradicional: cuidando nuestras opciones de privacidad en las redes sociales digitales, y filtrando seguidores potencialmente agresivos. Para ello, es importante tener una adecuada cultura del uso de las tecnologías de información, sobre todo en la población juvenil, que la usa con mayor frecuencia y es la más vulnerable.

[email protected], [email protected], [email protected], [email protected]

1 H. J. Escalante, M. Montes-y-Gómez, L. Villaseñor-Pineda, M. Luis Errecalde: Early text classification: a Naïve solution. WASSA@NAACL-HLT 2016: 91-99

2 G. Dulac-Arnold, L. Denoyer, P. Gallinari. Text Classification: A Sequential Reading Approach. Advances in Information Retrieval, Proc. of 33rd European Conference on IR Research, (ECIR’11) Vol. 6611 of LNCS, pp. 411–423, Springer, 2011

3 H. J. Escalante, E. Villatoro, S. E. Garza, A. P. López, M. Montes-y-Gómez, L. Villaseñor-Pineda.Early Detection of Deception and Aggressiveness using Profile-Based Representations. Expert Systems with Applications, 2017